Méta-instruments à vent

Dernière mise à jour :

Analyse gestuelle pour le pilotage de méta-instruments à vent

Ce thème de recherche explore les modalités de contrôle physique des instruments à vent virtuels, notamment à partir des gestes de l'appareil phonatoire. Ces derniers peuvent être captés et analysés selon différentes approches telles que l'analyse du signal audio, de l'impédance acoustique, ou encore l'utilisation de capteurs de pression ou de débit d'air. Cette démarche s'inscrit dans le thème de recherche plus large du SCRIME visant à enrichir et élargir l'accès à la performance musicale en créant des dispositifs hautement expressifs pilotés par des gestes minimalistes.

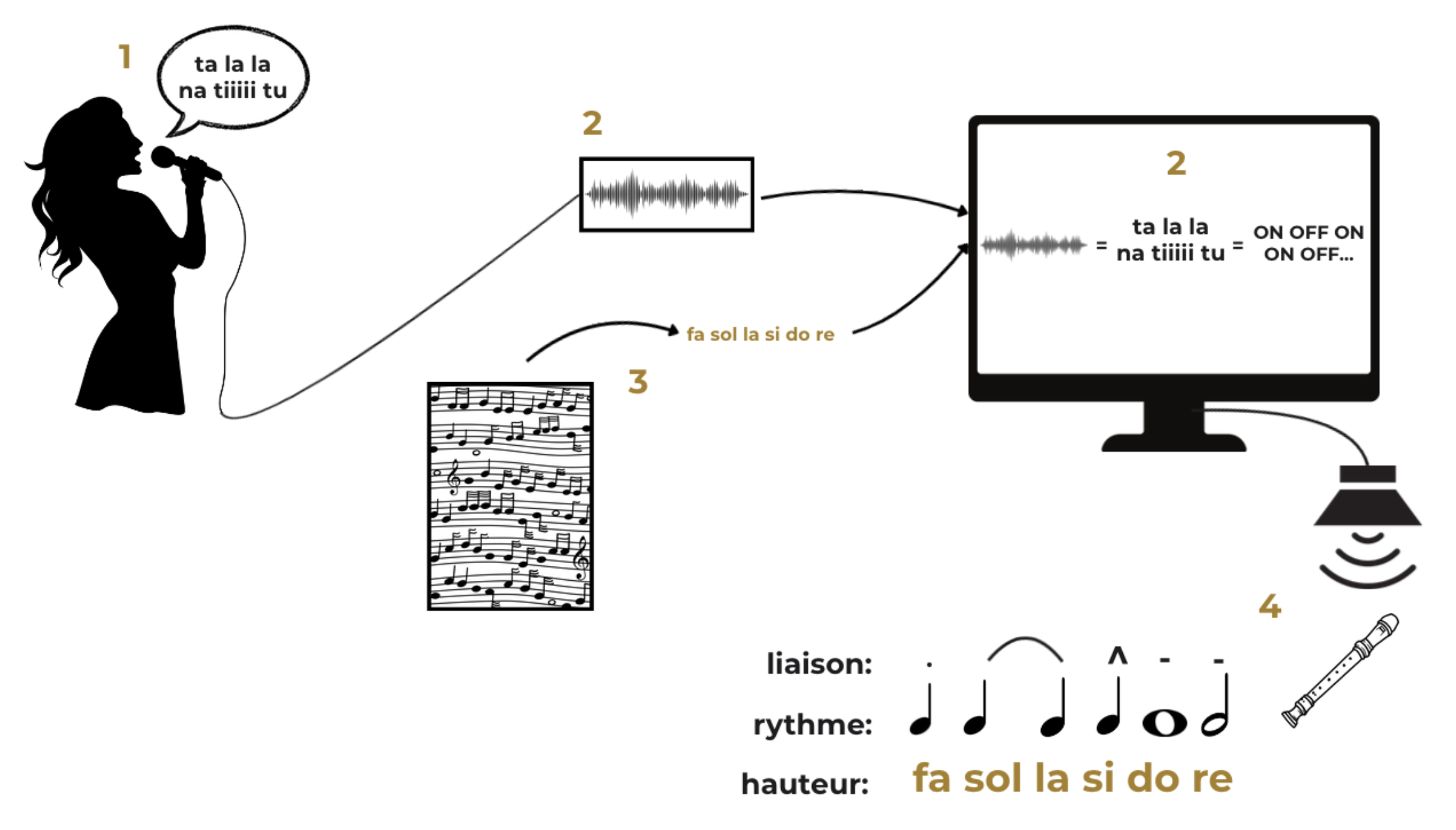

Les premières recherches ont eu pour objectif de tester le contrôle de l'application MidifilePerformer à partir d'une interface physique inspirée d'une embouchure d'instrument à vent. L'idée était d'exploiter exclusivement les gestes vocaux sans utiliser d'autres parties du corps que l'appareil phonatoire. Le processus de formation des notes à l'œuvre dans un instrument à clavier est très différent de celui d'un instrument à vent : avec un clavier les gestes des doigts sont directement liés aux notes (hauteur et enveloppe dynamique), alors que dans les instruments à vent les doigts sont responsables du contrôle de la hauteur et les gestes de l'appareil phonatoire agissent sur l'enveloppe dynamique et le timbre. De plus les instruments à vent sont monophoniques, et les liaisons entre les notes peuvent provenir des gestes vocaux ou digitaux. Il a donc fallu employer un instrument virtuel adapté au projet, la plupart proposant des modalités de contrôle MIDI pensées pour les interfaces à clavier, et sélectionner un répertoire musical spécifique. Nous nous sommes pour l'instant limités à l'interprétation de partitions monophoniques. Un premier stage a été effectué pendant l'année 2025 avec pour objet l'étude du contrôle de l'application MidifilePerformer à partir de l'analyse audio des gestes vocaux.

Pilotage d'instruments à vent virtuels à partir du signal audio de la voix

Ce premier stage effectué en 2025 par Noémie Kegl--Tourneix était intitulé Interprétation musicale expressive affranchie de technicité par une famille de gestes inspirés des instruments à vent. Dès le départ il a été décidé de suivre la piste de l'analyse audio. L'idée originelle était de créer une simple embouchure pourvue d'une capsule à électret reliée à un microcontrôleur pour aboutir à un prototype de contrôleur MIDI générant des évènements de notes MIDI à partir des seuls gestes de l'appareil phonatoire. La première preuve de concept a été développée avec un simple microphone dynamique relié à un ordinateur. Finalement tout le stage a consisté à exploiter ce dispositif car il est peu onéreux et accessible à un grand nombre d'utilisateurs.

L'approche adoptée pour l'analyse du signal audio consiste à classer en temps-réel les sons captés selon différentes catégories correspondant à des configurations particulières de l'appareil phonatoire. Les catégories "a", "i", "t", "l" (correspondant respectivement au son produit par la lettre), et "s" (correspondant au silence) ont été initialement choisies, deux voyelles éloignées au niveau physiologique, une occlusive et une fricative constituant un ensemble minimal mais représentatif des diverses catégories existantes de sonorités vocales.

Le signal brut est analysé pour produire à intervalles réguliers des vecteurs contenant les MFCC (Mel Frequency Cepstral Coefficients) auxquels sont concaténés les descripteurs de zero-crossing rate et de pente moyenne. Ces vecteurs sont agrégés en matrices de séries temporelles successives, et les matrices obtenues sont classées par un algorithme de KNN (K-Nearest Neighbors). Le KNN est entraîné à partir d'un dataset créé manuellement : une série de "taaa tiii laaa liii" articulés et détachés est enregistrée puis labellisée à la main dans un éditeur de son. Le KNN est construit à partir du résultat du même procédé d'analyse en matrices de séries temporelles appliqué à cet enregistrement audio labellisé. Afin d'optimiser le processus, une réduction de dimension est appliquée aux matrices grâce à l'ACP (Analyse en Composantes Principales) du dataset. Les labels produits en flux continu par cette chaîne de traitement sont ensuite fournis en entrée à un automate qui implémente l'heuristique de production des messages MIDI à partir d'un flux de labels.

Le prototype développé permet de générer des suite d'évènements MIDI correspondant à des notes jouées legato ou staccato (voir schéma ci-contre).

Le système a été testé avec succès en tant qu'interface de contrôle du logiciel Midifile Performer. L'enveloppe dynamique RMS (Root Mean Square) du signal audio est utilisée comme paramètre de contrôle continu pour piloter l'intensité du son. Afin de faciliter son utilisation par le plus grand nombre d'utilisateurs, la fin du stage a consisté à développer une interface graphique permettant de visualiser la réponse du système aux sons produits grâce à un d'entraîner soi-même un modèle